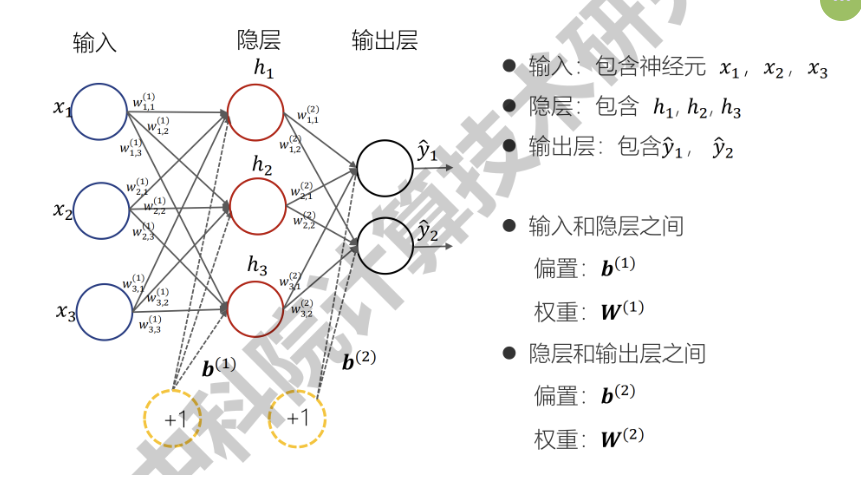

神经网络构成

+ 输入层

+ 隐层

+ 输出层

+ 每一层由多个神经元组成

+ w 是权重,b 是偏置,h 是激活函数

层层递进,可以理解为朝着更具体的方向深入(比如:形状 -> 轮廓 -> 图像)

损失函数

设置不同的函数形式,反映神经网络的输出值与数据的真实值之间的差异。

常用损失函数:

+ 均方差损失函数

+ 交叉熵损失函数

激活函数

在神经网络中,除了层内的线性函数转化,还需要在隐层的每个神经元设置对中间输出的一个非线性函数转化,进而引入非线性因素。这个非线性函数就是激活函数。

常用激活函数:

+ sigmoid

+ RELU

反向传播

根据神经网络正向传播计算损失函数,再通过链式求导,沿着相反方向计算每个权重的梯度,根据梯度来调整权重,使得在下一次正向传播能得到与真实值更接近的输出。

神经网络运行的整个过程就是正向传播与反向传播的迭代

泛化能力

对于一个训练好的模型,在遇到它从未见到过的数据时,可以准确作出预测的能力,就是泛化能力。

正则化

抑制过拟合现象的一系列方法

鲁棒性

具体指:在存在干扰,恶劣的条件下,依然能保持正常稳定的能力。

在深度学习中指:不考虑测试数据集,而看模型在真实数据集下的工作能力。

与过拟合联系紧密

数据集

深度学习中的数据集分类:

+ 训练集:训练模型参数

+ 验证集:确定一些神经网络超参数

+ 测试集:评估模型训练效果

交叉验证

将数据集分成多份,将每一份数据都作为测试集一次,剩下的多份作为训练集,进行多轮验证,取平均值作为最终结果,这个过程就是交叉验证。

分成 k 份,称作 k 折交叉验证。

评论